AI中的偏见:揭示GPT生成文本的潜在不公平

前言

人工智能(AI)在如今的科技行业中扮演着越来越重要的角色。然而,我们常常忽视了AI系统中的偏见和不公平性,并往往认为它们是客观的。本文将探讨GPT生成文本时可能存在的偏见和不公平,并揭示AI中的隐含偏见。

GPT生成文本:AI算法的杰作

GPT(Generative Pretrained Transformer)是一种基于深度学习的自然语言处理模型。它使用无监督学习的方式,通过阅读大量的文本数据来预测下一个词的可能性。GPT模型的优势在于其生成的文本流畅、连贯,几乎可以媲美人类的写作能力。

然而,正如人类撰写文本时可能存在偏见一样,GPT生成的文本也可能受到偏见和不公平的影响。下面我们将深入研究AI中的偏见。

AI中的偏见:来自数据的影响

GPT模型的训练数据通常来源于互联网上的大型语料库,其中包含大量的文本数据。然而,互联网本身存在着社会偏见和不平等现象,这些偏见和不平等现象也会被反映在GPT生成的文本中。

例如,当给予GPT模型一个问题“女人是什么样的?”时,它可能会生成一些含有性别刻板印象的回答,例如“女人应该温柔、体贴”,这就是典型的性别偏见。这是因为在训练数据中,女性往往被描述为符合社会对女性的刻板印象。

同样地,种族、年龄、职业等因素也可能影响GPT生成的文本。如果在训练数据中存在某种程度上的偏见,那么GPT生成的文本也可能会反映这种偏见。

揭示GPT生成文本的潜在不公平

AI中的偏见和不公平性不仅仅是对个体的伤害,它还可能对社会和文化产生深远的影响。当GPT生成的文本在广泛传播时,这种偏见可能被误解为客观事实,进一步加剧了社会不公平。

为了解决这个问题,研究人员和工程师们正在努力研发更加公正和中立的AI系统。他们通过检查和消除训练数据中的偏见、设计公平的评估指标以及提供更加透明的AI决策过程来寻求解决方案。

然而,解决AI中偏见的问题并不简单,需要多方共同努力。政府、学术界、工业界都应该密切合作,确保AI系统在设计和实施中不会带来偏见和不公平性。

结语

AI中的偏见和不公平对我们的社会和文化产生了深远的影响。对GPT生成的文本中的潜在偏见进行揭示和理解是解决这个问题的第一步。进一步的研究、开放和透明的讨论将推动AI系统的进步,使其更加公正、中立,为我们的社会和人类福祉做出积极贡献。

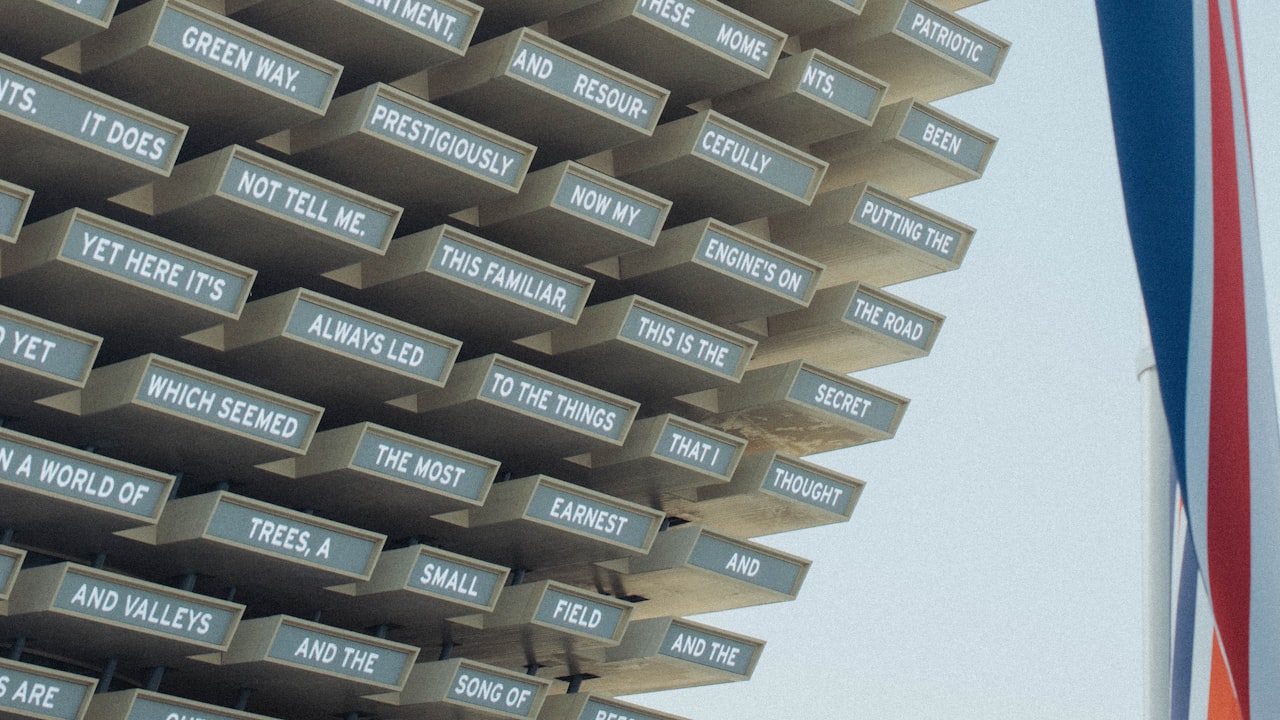

注:图片来源于Unsplash APl,关键词为"AI bias"。

参考文献:

- Caliskan, A., Bonawitz, K., Voss, C. R., and Miller, B. 2017. "Semantics derived automatically from language corpora contain human-like biases". Science 356(6334): 183–186.

- Garg, N., Schiebinger, L., Jurafsky, D., and Zou, J. 2018. "Word embeddings quantify 100 years of gender and ethnic stereotypes". Proceedings of the National Academy of Sciences 115(16): E3635–E3644.

版权属于:戏人看戏博客网

本文链接:https://day.nb.sb/archives/99039.html

若无注明均为戏人看戏原创,转载请注明出处,感谢您的支持!